Outils et ressources pour apprendre et maîtriser les NeRFs et le Gaussian Splatting.

Aujourd'hui, nous allons plonger dans l'univers des NeRFs et du Gaussian Splatting avec Michael Rubloff.

Cet article est réalisé en collaboration avec Gabriele Romagnoli, il est l’auteur original de cette interview et nous a donné l’autorisation en exclusivité de traduire son contenu en français. Gabriele est une pointure dans le domaine des technologies immersives dont il est avant tout un passionné. Cette interview est tirée de sa newsletter que nous vous recommandons pour plus d'interviews avec des fondateurs et créateurs à l'intersection de la XR et de l'IA.

Aujourd'hui, nous allons plonger dans l'univers des NeRFs et du Gaussian Splatting avec Michael Rubloff. Pour la mise en avant du produit, je vais partager un flux de travail et un outil que vous pouvez utiliser pour explorer vos captures de splats en VR. Allons-y !

Interview avec Michael Rubloff

Dans cet épisode, nous plongeons dans l'univers des champs de radiance neuronaux (NeRFs) avec Michael Rubloff. Nous découvrons comment les NeRFs révolutionnent la technologie 3D, leurs différences avec la photogrammétrie traditionnelle, ainsi que leur potentiel dans l'informatique spatiale et la réalité étendue (XR).

Qu'est-ce que les Neural Radiance Fields (NeRF) et comment sont-ils fondamentalement différents de la photogrammétrie ?

Michael Rubloff : Les NeRFs, ou Neural Radiance Fields, ont été inventés en 2020. Je les ai découverts début 2022 et j'ai décidé de lancer le site neuralfields.com pour documenter l'évolution de cette nouvelle technologie. Les NeRFs sont la première itération des radiance fields, qui se sont maintenant diversifiés en plusieurs variantes telles que le 3D Gaussian splatting. Les NeRFs sont entraînés via un réseau neuronal, et contrairement à la photogrammétrie, ils peuvent traiter des informations lumineuses, y compris les réflexions et les ombres, afin d'atteindre une qualité réaliste. La photogrammétrie a d'immenses applications commerciales et a été largement développée au cours des cinquante dernières années, mais les NeRFs et les radiance fields sont totalement nouveaux, offrant des fonctionnalités qui n'étaient pas disponibles auparavant. En plus de cela, les NeRFs sont plus rapides et produisent des rendus plus réalistes.

Vous avez mentionné que les NeRFs sont plus rapides. Est-ce le cas à la fois pour la capture des données et leur traitement ?

Michael Rubloff : Pour la phase de capture elle-même, cela dépend. Si vous créez un objet avec un NeRF, cela ne devrait pas prendre plus de quelques minutes pour la capture. Si vous utilisez un drone pour capturer une zone plus grande, cela pourrait être similaire en durée à la photogrammétrie. Cependant, lorsque vous appliquez la méthode structure-from-motion aux données et que vous les importez dans un outil capable de créer un NeRF, comme Luma ou Polycam, vous n'avez qu'environ 15 à 20 minutes pour obtenir le produit final, ce qui est vraiment rapide comparé à la photogrammétrie "standard".

Qu'est-ce qui vous a amené dans ce domaine ? Quel est votre parcours ?

Michael Rubloff : J'ai découvert les NeRFs en expérimentant avec le scanner LiDAR de mon iPhone 12 pendant la pandémie, ce qui m'a conduit à une plongée approfondie de plusieurs années dans la numérisation 3D. Je voulais des captures photo-réalistes, en particulier de personnes, et je pensais au départ que le LiDAR était la solution. Début 2022, j'ai trouvé un post sur le NGP instantané, qui était exactement ce que j'essayais d'atteindre. Sans ordinateur, j'en ai emprunté un à un ami et acheté une carte graphique 3080. Après beaucoup d'essais et d'erreurs, nous avons capturé des milliers de NeRFs et appris les meilleures pratiques. Il n'y avait pas de ressources disponibles au début, donc il était crucial pour moi de comprendre comment ça fonctionnait.

Quelles ont été certaines des leçons que vous avez apprises au cours de ce parcours de capture de plus de 2 000 NeRFs ?

Michael Rubloff : Il est parfois préférable de ne pas trop réfléchir et de simplement sortir et capturer. Avoir certains réglages de caméra et une longueur focale appropriée est vraiment utile. Prenez des photos aussi larges que possible, utilisez un objectif fisheye si possible, et assurez-vous d'avoir une grande profondeur de champ. Une vitesse d'obturation rapide est essentielle. Des images nettes et claires sont cruciales. Introduire du parallaxe en se déplaçant en arc ou en cercle aide à mieux comprendre la scène.

Qu'en est-il du traitement des données ? Comment cela fonctionne-t-il ?

Michael Rubloff : Nous avons eu la chance de voir l'émergence de plateformes sans code telles que Luma AI et Polycam, où vous pouvez simplement glisser-déposer des images dans un navigateur web ou les télécharger depuis votre téléphone. Si vous utilisez des plateformes comme NeRF Studio ou instant NGP, vous devrez avoir une certaine familiarité avec la ligne de commande. Le prétraitement est crucial, où l'étape de structure-from-motion aligne toutes les images d'un jeu de données pour comprendre leur agencement spatial. Des méthodes comme Colmap, avec des paramètres comme séquentiel ou exhaustif, sont utiles à cette étape.

Préférez-vous utiliser des plateformes web comme Luma et Polycam, ou vous tournez-vous davantage vers des méthodes basées sur PC ?

Michael Rubloff : Mon approche est un peu dispersée car j'essaie de les traiter sur autant de plateformes que possible en même temps. Pour la facilité d'utilisation, Luma et Polycam sont définitivement les plus simples. Cependant, j'adore utiliser instant NGP parce que vous pouvez voir la scène 3D se développer à partir de rien, ce qui ressemble à regarder un film photographique se développer dans un laboratoire. C'est une expérience très satisfaisante.

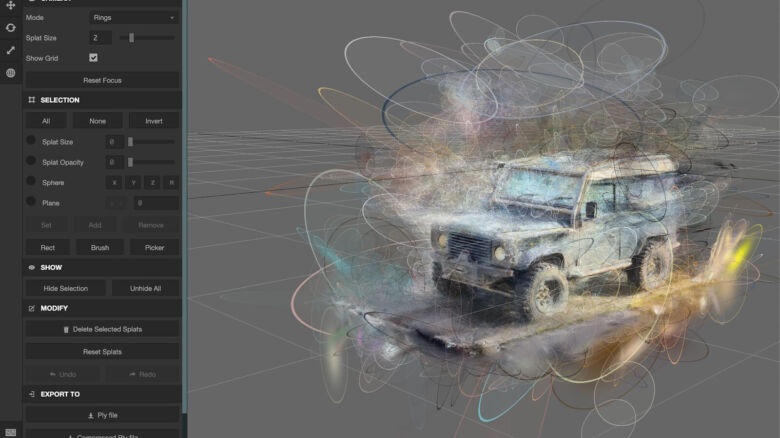

Comment éditez-vous et nettoyez-vous les NeRFs et les splats gaussiens ?

Michael Rubloff : Les NeRFs ne sont pas encore très modifiables, mais si vous utilisez instant NGP, vous pouvez entrer en réalité virtuelle et éditer les éléments flottants à l'aide des contrôleurs manuels. Pour les splats gaussiens, il y a eu beaucoup de travail sur l'édition et la création de visionneuses pour les intégrer dans un navigateur web. Des plateformes comme PlayCanvass, SuperSplat, et des visionneuses créées par des auteurs comme AnyMatter15 permettent de prendre les fichiers résultants et de les éditer. Des applications comme Kiri Engine disposent également d'éditeurs internes pour supprimer les éléments flottants.

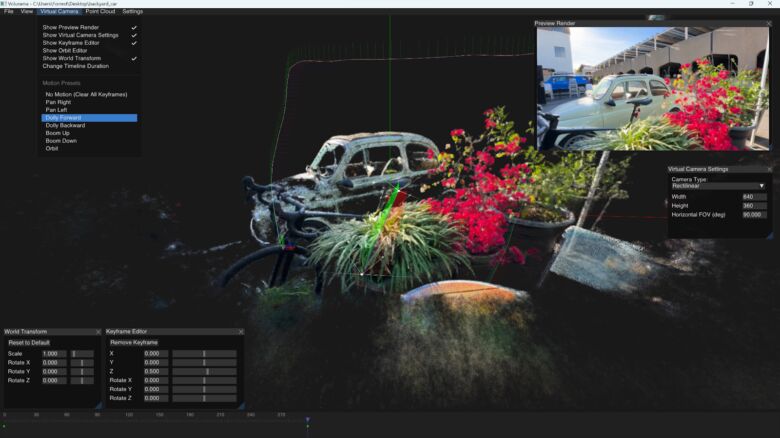

Quelles sont les étapes pour voir ces NeRFs et splats en VR ?

Michael Rubloff : C'est assez simple. Pour les NeRFs, vous entraînez le NeRF dans instant NGP, puis vous vous connectez via Steam Link avec votre casque. Pour le Gaussian splatting, il existe une plateforme appelée Gracia VR, qui permet de visualiser les splats en VR. Luma prend également en charge la réalité virtuelle via leur bibliothèque webGL, permettant la visualisation des fichiers splat en VR.

Comment voyez-vous les NeRFs contribuer à l'informatique spatiale et à la réalité étendue (XR) ?

Michael Rubloff : Ils sont directement liés les uns aux autres. Il y a eu un grand changement de priorités chez les grandes entreprises technologiques pour adopter l'informatique spatiale. Les NeRFs seront un outil polyvalent pour ces entreprises, offrant des avantages aux clients qui pourront vivre des expériences immersives en 3D. Parmi les applications potentielles, on trouve la formation en réalité virtuelle, où les formateurs peuvent fournir des démonstrations réalistes, et des outils éducatifs, où les étudiants peuvent observer des chirurgies et d'autres procédures complexes dans un environnement 3D.

Dans quelle direction voyez-vous cette technologie aller à l'avenir ?

Michael Rubloff : L'avenir de cette technologie est très excitant. Il pourrait être possible d'avoir des NeRFs instantanés, où vous appuyez sur le déclencheur de votre téléphone et vous avez immédiatement une scène 3D. Le plafond de la technologie n'est pas limité par la fidélité, mais par les capacités de calcul et d'ingénierie. Des articles comme VR NeRF de Meta montrent que des NeRFs de qualité niveau IMAX sont réalisables, et à mesure que la technologie continue de s'améliorer, les possibilités sont illimitées.

Retrouvez l'interview complète ici.