Les différentes techniques de rendu 3D

Qu’il s’agisse de reproduire un lieu, de créer des avatars interactifs ou de développer des expériences immersives, il est essentiel de choisir la méthode la plus adaptée à ses objectifs.

Dans l’univers en pleine effervescence de la capture et du rendu 3D, de nombreuses techniques émergent, chacune avec ses spécificités, ses avantages et ses limites. Qu’il s’agisse de reproduire un lieu, de créer des avatars interactifs ou de développer des expériences immersives, il est essentiel de choisir la méthode la plus adaptée à ses objectifs. À travers ce comparatif détaillé, nous vous proposons un tour d’horizon des cinq principales technologies du moment – de la reconstruction 3D classique au Gaussian Splatting, en passant par les NeRFs et la vidéo volumétrique – pour vous aider à mieux comprendre leurs atouts, leurs contraintes et leurs cas d’usage idéaux.

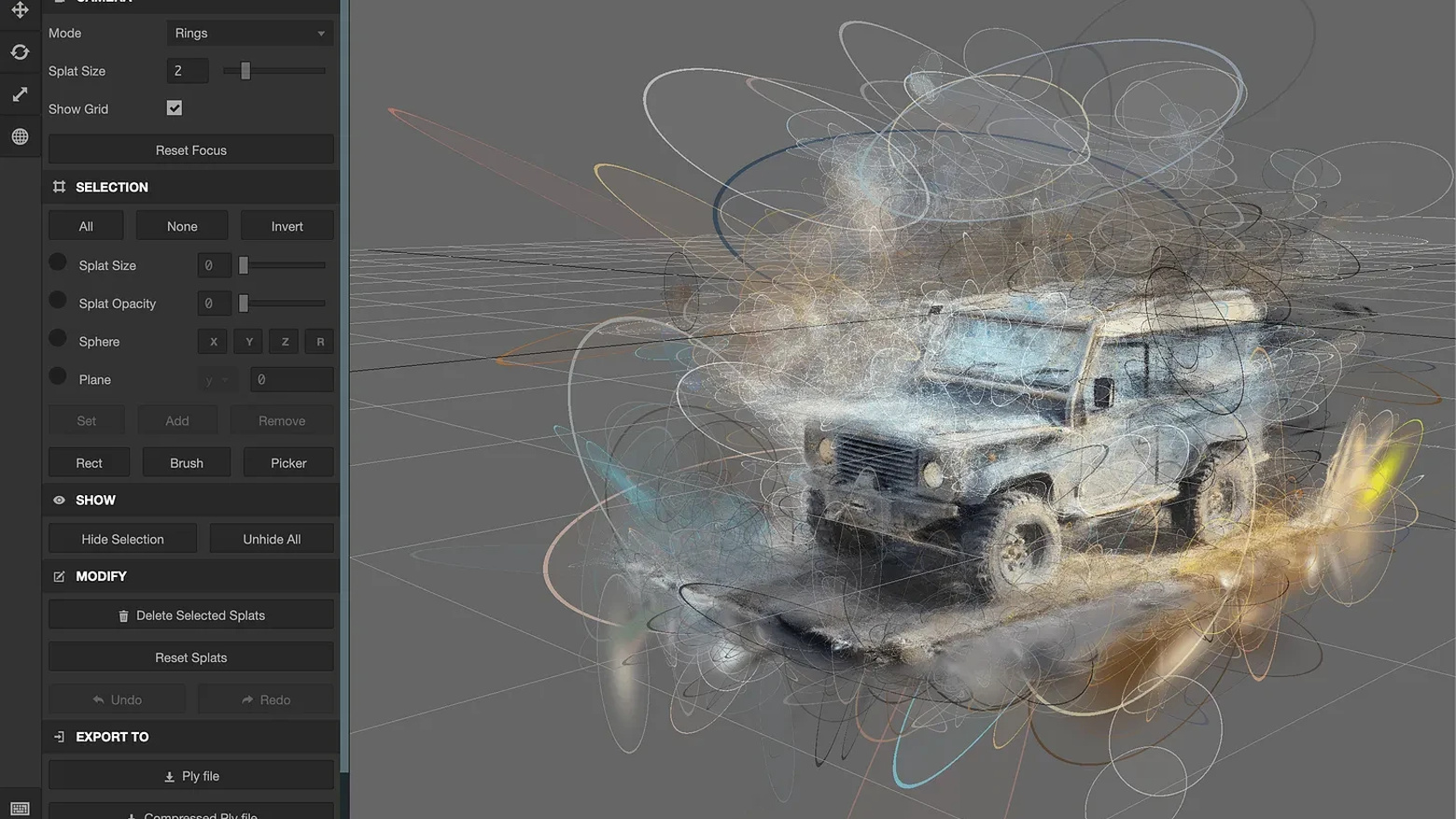

1. Gaussian Splatting – Le Guide Expert

🧾 Définition

La Gaussian Splatting est une technique de rendu 3D (ou 4D dans certains cas) innovante qui remplace les maillages par un ensemble de points flous gaussiens projetés dans l’espace. Ces points possèdent :

une position 3D,

une forme (anisotrope, donc allongée ou aplatie),

une couleur et opacité,

une orientation.

Ils sont ensuite optimisés à partir d’un ensemble de vues réelles pour produire un rendu photo-réaliste et interactif.

📦 Cas d’usage principaux

Visites virtuelles réalistes (musées, immobilier, tourisme)

Reconstitution de lieux pour réalité augmentée/virtuelle

Digital twins visuels pour la communication ou la formation

Contenus immersifs web (navigateur WebGL/WebGPU)

Archivage visuel (musées, archéologie)

✅ Avantages

Rendu temps réel, même sur navigateur

Très bon rapport qualité/poids

Pas besoin de modélisation manuelle

Très bon réalisme visuel

Intégration possible dans WebXR, Unity, Unreal

❌ Inconvénients

Scène figée : pas d’animation ni de stylisation

Besoin de bon GPU pour l’entraînement

Moins éditable qu’un modèle mesh

Pipeline encore technique (Python, COLMAP, CUDA…)

⚙️ Produire une scène soi-même

1. Capture

📸 30 à 100 photos autour de l’objet ou du lieu

🎥 Ou une vidéo (à découper en frames via ffmpeg)

2. Calcul des poses caméra

🔧 Utiliser COLMAP pour reconstituer le positionnement 3D de chaque vue

🎯 Output : poses + calibration caméra

3. Préparation des données

📁 Convertir le format COLMAP pour le pipeline GS via les scripts fournis (dans le repo officiel)

4. Entraînement

🚀 Repo officiel : https://github.com/graphdeco-inria/gaussian-splatting

💻 Environ 1h d’entraînement sur une RTX 3080+

🛠️ Dépendances : PyTorch, CUDA, Python ≥ 3.8

5. Visualisation / Export

👁️ Visualiseur OpenGL / WebGL fourni

🌐 Intégration dans Unity / Unreal / WebXR possible

🧪 Évaluation

2. NeRF (Neural Radiance Fields) – Le Guide Expert

🧾 Définition

Le NeRF est une technique de rendu 3D introduite en 2020 qui modélise une scène non pas avec des points ou des maillages, mais avec un réseau de neurones. Ce réseau apprend à prédire la couleur et la densité de tout point de l’espace 3D, en fonction de la position et de la direction de la caméra.

Cela permet de reconstruire une scène complète à partir de quelques images, avec un réalisme impressionnant, particulièrement pour les effets de lumière et de transparence.

📦 Cas d’usage principaux

Reconstitutions réalistes de scènes réelles

Cinématographie 3D (effet "bullet time")

Archivage visuel (musées, art, lieux historiques)

Effets visuels en post-prod

Création de contenus immersifs passifs

✅ Avantages

Très bon réalisme visuel

Reproduit bien les effets complexes (transparence, lumière indirecte)

Aucune modélisation manuelle

Fort potentiel créatif (effets de caméra impossibles en vrai)

❌ Inconvénients

Rendu non temps réel (classique)

Pipeline très technique (Python, CUDA, PyTorch)

Scène figée (pas d’animations dynamiques)

Modèle lourd et peu exploitable pour le web

⚙️ Produire un NeRF soi-même

1. Capture

📸 Environ 30 à 100 photos autour de la scène

🎥 Ou une vidéo convertie en frames

2. Estimation des poses caméra

🔧 Utiliser COLMAP (comme pour Gaussian Splatting)

3. Préparation des données

📁 Organisation des images + poses + calibrations

4. Entraînement

🚀 Framework recommandé : Instant-NGP (NVIDIA)

🛠️ Ou pour une implémentation pure NeRF : https://github.com/bmild/nerf

⏱️ Temps d’entraînement : 1 à 5 heures sur GPU performant

5. Rendu

⏳ Images générées image par image (pas temps réel, sauf si usage d’Instant-NGP)

🎞️ Export possible en séquences vidéo

🧪 Évaluation

3. Instant-NGP (NVIDIA) – Le Guide Expert

🧾 Définition

Instant-NGP, développé par NVIDIA, est une implémentation ultra-rapide de NeRF, basée sur des structures de données optimisées (multi-resolution hash encoding + tiny CUDA MLPs).

Elle permet d’entraîner un NeRF en quelques secondes à quelques minutes (d’où le “instant”) et d’en faire un rendu en temps réel, y compris dans un navigateur ou moteur de jeu.

📦 Cas d’usage principaux

Rendus 3D interactifs rapides à partir de photos

Réalité virtuelle/augmentée légère

Visualisations immersives dans Unity / Unreal

Démos ou prototypes de lieux scannés

Application dans le jeu vidéo ou le Web

✅ Avantages

Entraînement ultra-rapide (en 1 à 5 minutes)

Temps réel sur GPU moderne

Très bon compromis qualité/performance

Facile à tester en local

Parfait pour des expériences interactives

❌ Inconvénients

Toujours une scène figée

Pipeline toujours un peu technique

Peu de contrôle sur le style ou l’édition

Fonctionne mieux avec de nombreuses vues

⚙️ Produire un Instant-NGP soi-même

1. Capture

📸 50+ photos ou frames vidéo autour de la scène

💡 Lumière constante = meilleurs résultats

2. Caméra tracking

🔧 Utiliser COLMAP pour les poses caméra

📁 Exporter au format transforms.json (compatible NGP)

3. Entraînement

🧠 Utiliser le repo officiel : https://github.com/NVlabs/instant-ngp

💻 1 à 5 minutes d’entraînement sur GPU avec 6+ Go de VRAM

💡 Peut tourner en live training, visualisable en direct

4. Rendu et intégration

🌐 Export en glTF / point cloud / vidéo

🎮 Plugins pour Unity, Blender, WebGL

🧪 Évaluation

4. Reconstruction 3D par Mesh – Le Guide Expert

🧾 Définition

La reconstruction 3D par mesh consiste à capturer un objet ou une scène réelle via plusieurs photos ou scans, puis à créer un modèle 3D polygonal (souvent triangulaire). Cette technique s’appuie sur la photogrammétrie ou le scanning laser/LiDAR.

Contrairement aux approches neuronales comme NeRF ou Gaussian Splatting, ici, on obtient une géométrie explicite : un mesh (structure polygonale) + textures, directement exportable dans Unity, Blender, Unreal, etc.

📦 Cas d’usage principaux

Patrimoine (numérisation d’œuvres d’art, musées)

Jeux vidéo (intégration dans moteur de rendu)

Publicité produit (visualisation 360° réaliste)

E-commerce (fichiers 3D interactifs sur site)

Réalité augmentée (objets animables et intégrables)

✅ Avantages

Résultat éditable (topologie, UVs, textures)

Compatible avec tous les outils 3D

Idéal pour les scènes modifiables ou animables

Fidélité géométrique élevée sur petits objets

Résultat web-friendly (glTF, FBX, etc.)

❌ Inconvénients

Très dépendant de la qualité de la capture

Peut nécessiter beaucoup de post-prod manuelle

Moins performant pour les jeux de lumière complexes

Plus long à produire qu’Instant-NGP

⚙️ Produire un mesh 3D soi-même

1. Capture

📸 50 à 300 photos haute résolution sous tous les angles

🔄 L’objet doit être bien éclairé, sans reflets

2. Alignement / Calcul

🧠 Logiciels recommandés :

Metashape (pro)

Meshroom (gratuit, open source)

RealityCapture (rapide et puissant)

📍 Étapes :

Alignement des photos

Construction du nuage de points dense

Génération du maillage

Baken des textures

3. Post-traitement

🪄 Nettoyage dans Blender, ZBrush ou MeshLab 🎨 Optimisation des textures, retopologie si besoin 📦 Export en glTF, OBJ, FBX, etc.

🧪 Évaluation

5. Volumetric Video – Le Guide Expert

🧾 Définition

La volumetric video est une technologie de capture qui permet d’enregistrer des performances humaines ou des scènes en 3D avec mouvement, en combinant vidéo traditionnelle et reconstruction spatiale.

Concrètement, c’est comme filmer quelqu’un dans un cube, avec des dizaines de caméras tout autour, puis générer une vidéo jouable sous tous les angles, dans un espace 3D.

C’est l’un des rares formats où la personne bouge ET peut être vue de tous les côtés, en temps réel ou en post-production.

📦 Cas d’usage principaux

Communication immersive (interview 3D, témoignage)

Muséographie et art vivant

Réalité mixte : hologrammes, shows XR

Événementiel (avatars réalistes, scènes replayables)

Training ou learning immersif

✅ Avantages

Captation ultra-réaliste du mouvement

Peut être joué dans un moteur 3D comme Unity ou Unreal

Idéal pour créer une présence humaine forte

Compatible avec la réalité augmentée et les hologrammes

❌ Inconvénients

Coût de production très élevé

Besoin d’un studio spécialisé

Difficulté à éditer la séquence après capture

Poids des fichiers élevé (compression complexe)

⚙️ Produire une volumetric vidéo soi-même

1. Studio et matériel

🏢 Il faut accéder à un studio spécialisé (comme 4DViews, Microsoft Mixed Reality Capture, Evercoast, etc.)

📷 Environ 30 à 100 caméras synchronisées + fond vert

2. Tournage

🎬 L’acteur joue dans l’espace délimité

💡 Lumières homogènes et tenue adaptée à la capture

3. Traitement

🖥️ Reconstruction 3D + synchronisation temporelle

🧠 Encodage volumétrique (souvent en .mp4v, .vologram, ou formats maison)

4. Diffusion

🌐 Intégration dans moteurs 3D (Unreal, Unity) ou applications WebAR / mobile

📱 Visualisation possible en AR via 8thWall, Niantic, etc.

🧪 Évaluation

Chaque technique possède ses forces et ses contraintes, et il n'existe pas de solution universelle : tout dépend du type d'expérience souhaitée, du niveau de réalisme attendu, du budget disponible et de l'usage final (web, XR, événementiel…). Pour vous aider à choisir rapidement la technologie la plus adaptée à votre projet, voici un tableau de synthèse des principaux usages recommandés.